¶ 🚀 Installation de Open-WebUI

Open-WebUI est une interface graphique permettant d'interagir facilement avec des LLM exécutés en local via Ollama. Cette page détaille les étapes pour l'installer et le lancer en utilisant Docker.

📖 Référence officielle : Guide Open-WebUI - Quick Start

¶ 🛠️ Étapes d'installation

¶ 1️⃣ Installer Ollama

Avant d’installer Open-WebUI, assurez-vous que Ollama est installé et fonctionnel sur votre machine.

¶ 2️⃣ Récupérer l’image Docker

Téléchargez l’image Docker de Open-WebUI avec la commande suivante :

docker pull ghcr.io/open-webui/open-webui:main

¶ 3️⃣ Lancer le conteneur

Exécutez Open-WebUI en créant un conteneur Docker :

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

⏳ Attendez quelques instants le temps que le service démarre.

¶ 4️⃣ Accéder à l'interface

Une fois lancé, ouvrez votre navigateur et rendez-vous sur :

🔗 http://localhost:3000

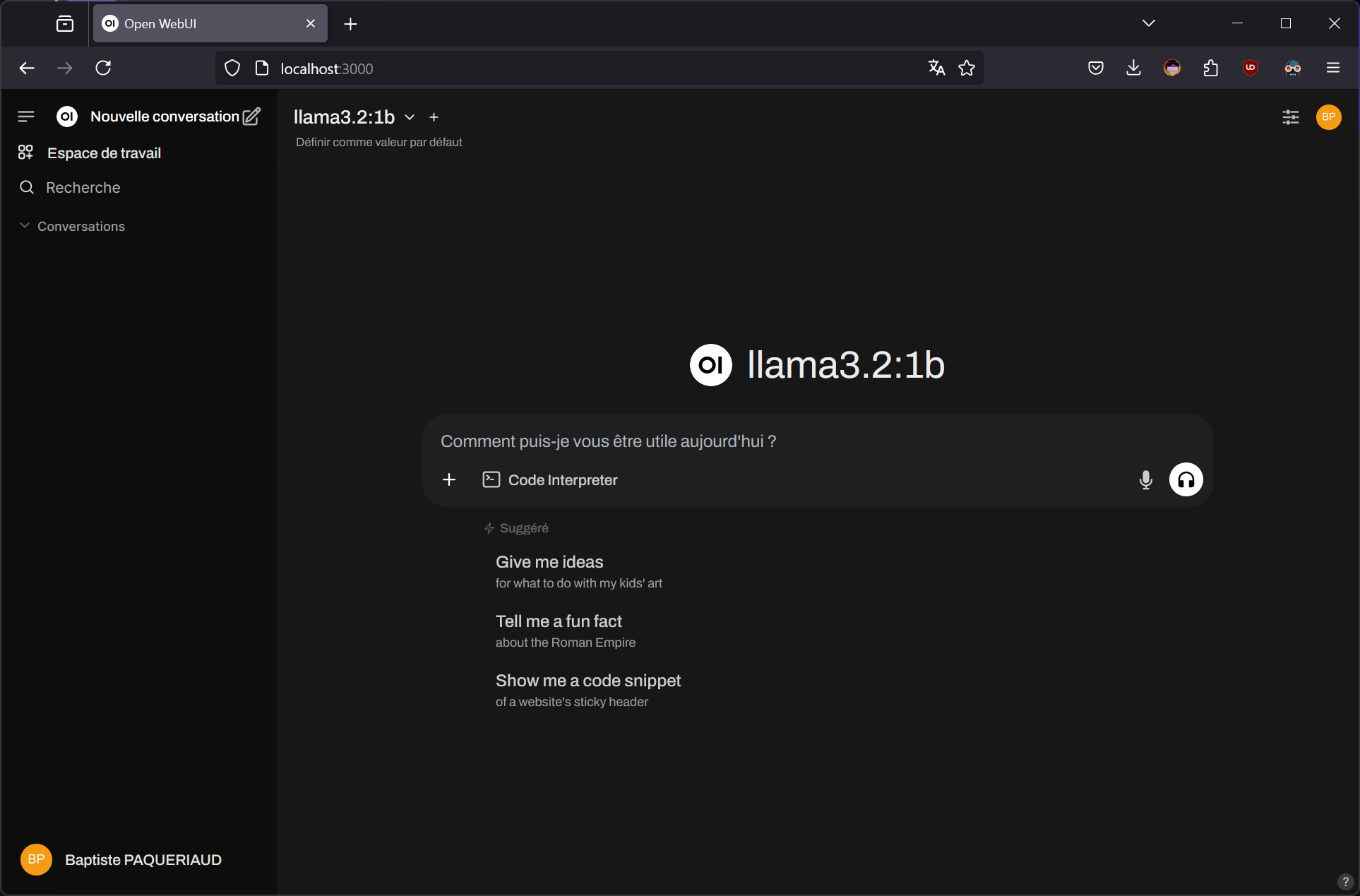

¶ 🎨 Interface Open-WebUI

Voici un aperçu de l'interface :

Une fois en place, vous pourrez tester différents modèles LLM via une interface intuitive. 🚀